Na portalu Wyborcza.biz kilka dni temu ukazał się tekst, którego autorem miał być Bolesław Breczko, ale tak naprawdę stworzony przez sztuczną inteligencję. Podpisany pod tekstem dziennikarz ten fakt zdradził dopiero w poniedziałek, podkreślając, że nikt – nawet redaktorzy, którzy przygotowywali materiał do emisji – nie wiedział o jego „eksperymencie społecznym”. – To był jednorazowy eksperyment – podkreśla w rozmowie z portalem Wirtualnemedia.pl Breczko.

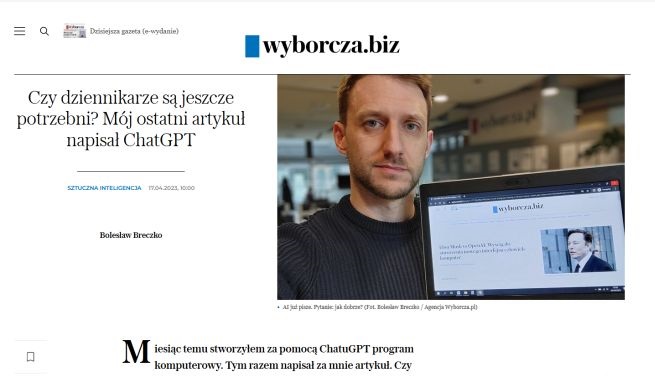

ChatGPT, udostępniony przez firmę OpenAI, napisał za Bolesława Breczko tekst pt. „Elon Musk vs OpenAI: Wyścig do stworzenia nowego interfejsu człowiek-komputer”. Ale autor – świadomie decydując się na społeczny eksperyment – nikomu w redakcji nie zdradził faktycznego autorstwa, tylko przesłał tekst do zredagowania wydawcom.

Dlaczego tak postąpił? „Nie chciałem nikogo wprowadzać w błąd, oszukać, uważam, że teksty pisane przez AI powinny być wyraźnie oznaczane. Tylko w ten sposób mogłem sprawdzić, czy ktoś rozpozna, że materiał nie jest stworzony przez człowieka. Tekst podpisany był moim imieniem i nazwiskiem, ale puściliśmy oko: daliśmy tag pod tytułem “sztuczna inteligencja”– pisze autor w poniedziałkowym wyjaśnieniu do eksperymentu.

Gdy wreszcie Breczko zdradził, że to nie on jest autorem tekstu, zapytał o opinię na jego temat kilku redaktorów. – Zdania (w tekście – red.) są bardzo okrągłe i ogólne, brakuje im pazura. Całość jest bardzo zachowawcza, a styl pasuje raczej do studenta pierwszego roku dziennikarstwa bez doświadczenia niż do ciebie. Tekst jest poprawny, ale to taka dolna granica tego, co powinniśmy publikować – ocenił akceptujący tekst na portal Maciej Drzewicki.

Ogórek: Chcieliśmy zweryfikować możliwości AI

W rozmowie z portalem Wirtualnemedia.pl Sebastian Ogórek, szef Wyborcza.biz mówi, że publikację tekstu autorstwa AI redakcja traktuje „stricte eksperymentalnie”, jako sprawdzenie umiejętności sztucznej inteligencji na jej obecnym poziomie. – Chcieliśmy zweryfikować, czy rzeczywiście jest tak dobra, rewolucyjna i jednak niebezpieczna, jak się powszechnie uważa. Wcześniej mieliśmy też tekst dotyczący pisania przez ChatGPT kodu programistycznego – aplikacja działa, sam z niej korzystam. Po tym materiale nasi czytelnicy sugerowali, że AI może być też zagrożeniem dla naszej pracy. Chcieliśmy to więc sprawdzić.

Eksperyment pokazał – zdaniem naszego rozmówcy – że choć sztuczna inteligencja jest w stanie napisać tekst, to nie jest w stanie zastąpić dziennikarza. – Nasza praca to nie tylko pisanie, ale też zdobywanie wiedzy, łączenie nieoczywistych faktów czy wymyślanie właśnie takich prowokacji dziennikarskich. Choć więc ChatGPT może być w przyszłości narzędziem dla dziennikarzy, to nie sądzę, by ich zastąpił. Raczej zmniejszy się rola mediaworkerów, piszących teksty reklamowe czy SEO – podkreśla Ogórek.

Sebastian Ogórek podkreśla też, że w Wyborcza.biz ten tekst został skrytykowany jako słaby przez grono redaktorów naczelnych, którzy nie wiedzieli, iż to materiał pisany przez AI. – To pokazuje, że potrafimy zadbać o jakość. Obawiam się jednak, że w innych redakcjach, gdzie liczą się tylko kliki, teksty oparte o ChatGPT już obecnie są pisane i publikowane, ale nikt się do tego nie przyznaje.

Breczko: Przeszkodą jest tylko poprawa stylu AI

Autor eksperymentu, Bolesław Breczko, mówi portalowi Wirtualnemedia.pl, że jego zdaniem AI „już teraz może pisać artykuły za dziennikarzy”. – Oczywiście, nie za dziennikarzy „Gazety Wyborczej”, bo w naszej redakcji przykłada się dużą wagę do poziomu tekstów. Niestety, na rynku mediów internetowych nie jest to standardem – tam, gdzie bardziej niż styl i poziom liczy się szybkość i liczba artykułów, ChatGPT nawet lepiej sobie poradzi od człowieka. Jest szybszy, nie robi literówek i stawia przecinki we właściwych miejscach.

Tekst napisany przez ChatGPT dla Wyborcza.biz powstał jako jednorazowy eksperyment – podkreśla nasz rozmówca. – Już samo jego przeprowadzenie, niezależnie od rezultatu, jest oznaką tego, jak wysoki poziom osiągnęła generatywna sztuczna inteligencja. Chociaż redaktorki i redaktorzy „Wyborczej” mieli do tekstu zastrzeżenia, to nikt nie zorientował się, że nie napisał go człowiek. Artykuł był „ludzki”, ale słaby.

Jeśli ChatGPT produkuje dziś „ludzko brzmiące artykuły”, a jedynym problemem jest ich poziom – to przeszkody nie stanowi już kwestia rozwoju technologii, a raczej odpowiednie „nauczenie” programu lepszego pisania –uważa Bolesław Breczko. – W kolejnej wersji artykułu poleciłem ChatGPT, aby unikał „okrągłych” zdań, które nie wnoszą nowych informacji, a które były jednym z głównych problemów opublikowanego artykułu. Ta nowa wersja mogłaby oszukać jeszcze większą liczbę osób, a jej „napisanie” zajęło mi kilkanaście sekund.

Kto odpowiada za teksty pisane przez ChatGPT?

ChatGPT stał się jednym z najpopularniejszych narzędzi bazujących na sztucznej inteligencji: pozwala tworzyć artykuły, wspomaga badaczy czy media. Jednak jego wykorzystanie rodzi też wątpliwości natury prawnej. Kto jest autorem danego tekstu? Czy prawa własności ma użytkownik, który „zlecił” AI napisanie tekstu czy sam czatbot?

– Przyjmuje się, że prawa do twórczości realizowanej przez sztuczną inteligencję nie podlegają ochronie prawno-autorskiej, bo jej wymogiem jest działalność twórcza. A więc z założenia działalność człowieka, wymagająca pewnej niezależności intelektualnej, procesów intelektualnych, których maszynom przypisać nie można – mówił w rozmowie z Wirtualnemedia.pl mec. Maciej Ślusarek, specjalizujący się w prawach autorskich.

Czy taki tekst może zniesławić i kto za to ponosi odpowiedzialność? Zdaniem mec. Ślusarka za ChatGPT odpowiedzialność ponosi spółka, która jest jego producentem i go udostępnia. – Porównałbym to z Wikipedią: ktoś ją nadzoruje, ale różni ludzie są autorami wpisów. A Wikipedia ponosi odpowiedzialność za to, co publikowane jest na jej stronach – zaznacza mecenas.

Firma OpenAI w połowie marca br. przedstawiła najnowszą wersję swojego modelu sztucznej inteligencji, GPT-4 (z tym modelem współpracował Bolesław Breczko). Model językowy ma być m.in. zdolny do zdania egzaminu prawniczego z bardzo dobrym wynikiem i udzielać poprawniejszych odpowiedzi niż jego poprzednie wersje, takie jak GPT-3 i ChatGPT.